基于In-suite processing的概念在存储控制上集成了计算加速的单元

在创业公司NGD的Keynote中,我们看到了他们和微软研究院完成的原型概念验证。基于In-suite processing的概念在存储控制上集成了计算加速的单元。这个概念和大部分在存储上做加速的方案类似,利用与数据存储比较靠近的优势来实现计算的offlaoding,从而降低延时。

NGD加速的应用是目前比较热门的CNN,类似Image的分类,人脸识别,以及车辆牌照识别之类的Edge端的应用。和以云端数据中心的形式存在的Google的TPU Pod不同,在Edge端的应用对于实时性要求更加严格,在5G出现之前,从端设备发送原始数据到云端处理的路径还是过长,因此Edge 计算和所谓的雾计算还是有很强大的生命了。使用Edge端的处理能力的好处主要是:1. 延时端,2. 减少了数据的传输量,不需要原始数据,特征数据就够了。

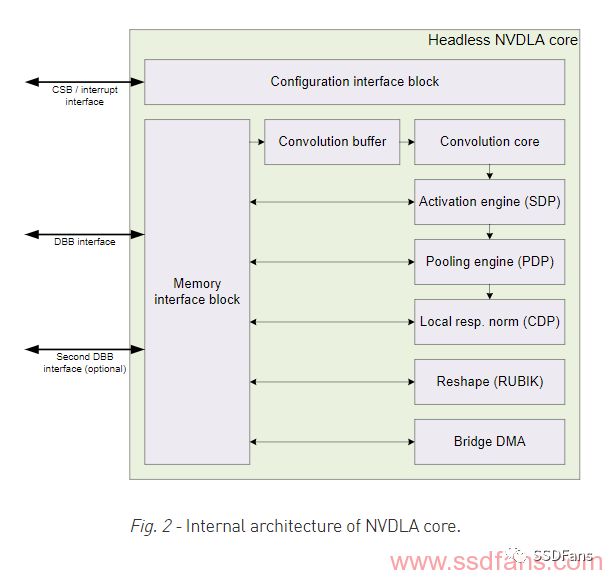

在FMS 2018上,类似的方案还有Marvell,Marvell宣布了一个概念芯片,他们把SSD的控制器和Nvidia的NVDLA结合在一起,推了了一个在端设备可以做深度学习推理的设备。

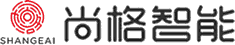

NVDLA的信息都在这个http://nvdla.org/primer.html,在2017年发布的时候,大家都惊呼可能要终结很多AI的创业公司的ASIC计划,因为NVDLA利用Nvidia在深度学习上的技术优势,开源这样一个Deep Learning Accelerator的设计,Nvidia的之前的大部分投入都在训练市场,对于推理来讲,需要通过新的硬件和架构来适配。从占领市场的角度,开源这个加速器的设计,对于增加话语权有着重要的意义。

在Marvell的展台上貌似没有看到这个概念芯片的具体信息。只是 在FMS2018的新闻稿来看到了一些信息。目前这种AI SSD关注的领域是数据分析市场,在具体的云端或者edge端大数据分析以及数据标注的应用上,可以使用AI SSD的加速功能。从NVDLA的内部框图上可以看出,NVDLA主要只是针对CNN的图像应用。

并不是Marvell这个一家公司这样,很多企业级控制器的厂家都在考虑这个方向;来自PMC加拿大班底的Netint.ca在FMS也展示了他们PCIE4.0 的SSD 控制器。

在SSD控制中集成了Video的处理单元。对于高清的H.265的处理,以为目前主流的方案还是CPU为主,因此单个Intel的X86的服务器级别的方案都在4-6路之间,而使用硬件加速可以在性能和功耗比上完胜。

之前在武汉存储半导体峰会上,A股上市公司国科微也提出了near data计算的概念,如何在SSD的设计中体现对AI workload的优化。目前在我天朝,AI发展最热的,也是各级领导最重视的就是安防了,人脸识别,行为判断,数人头,等等是安定团结的技术手段。其中的技术挑战也很多。

作为存储大数据分析加速,不能不谈一下BlueDBM,这个项目的韩国人从MIT毕业了,到了UIC Irvien,还是在谈大数据分析加速,在原有的框架上增加了很多的内容。

已经在做图计算以及Vertex的计算了,下一步是啥,参加过机器学习入门的人应该不陌生了。建议大家技术关注这个明星项目。之前在MIT的时候有广达的中研院支持,现在不知道会不有samsung的支持了。

和之前之四讲的计算加速类似,我们可以看到一个明显的趋势就是在SSD控制器中增加对near data计算的支持,把一些相对成熟的方案集成进去,这可能是企业级SSD控制器的新方向。最后,用一个韩国公司的SSD 控制器作为FMS 2018的结束了。他们是目前第一家使用RISC-V做SSD控制器,而且他们的性能和架构上和传统的控制器有很大的区别,值得学习。

原文标题:FMS 2018 之六:在存储中做AI

文章出处:【微信号:SSDFans,微信公众号:ssdfans】欢迎添加关注!文章转载请注明出处。